Измерительная информация и её количественные характеристики

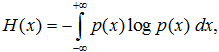

Измерение — это получение информации. С точки зрения теории информации, основы которой заложены американским учёным Клодом Шенноном, измеряемая величина до выполнения измерений обладает неопределённостью, которая характеризуется значением безусловной энтропии

где p(x) — плотность распределения вероятностей возможных значений измеряемой величины x. Энтропию H(x) можно трактовать как среднюю неопределённость источника информации до начала процесса измерений.

Количество информации I, получаемое в результате измерения, равно убыли неопределённости, то есть разности энтропий до и после измерения:

Здесь I — безусловная (априорная) энтропия, описываемая плотностью вероятностей p(x) измеряемой величины x до начала процесса измерений. H(x/xu) — условная энтропия, т. е. энтропия величины x при условии, что получен результат измерений xu. Условная энтропия — мера оставшейся неопределённости измеряемой величины x после получения отсчёта xu, вызванная наличием погрешностей, помех и собственных шумов в измерительной системе. Если бы в измерительной системе отсутствовали собственные шумы и погрешности измерений, то количество получаемой в эксперименте информации равнялось бы безусловной энтропии, т. е. неопределённость при измерениях снималась бы полностью и условная энтропия равнялась бы нулю. Очевидно, что в реальных измерительных системах это невозможно. Поэтому потери информации от помех, шума и случайных погрешностей измерений равны энтропии помех, шума и случайных погрешностей.

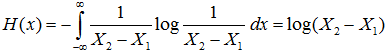

Если измерительный прибор имеет диапазон измерений от X1 до X2, в пределах которого ожидается получение измеряемого значения xu, то безусловная энтропия H(x) источника информации, при условии равномерного закона распределения вероятности получить отсчёт на шкале прибора  будет равна:

будет равна:

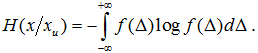

Условная энтропия определяется законом распределения погрешности Δ измерительного устройства и равна:

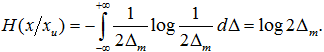

Если погрешность равномерно распределена на интервале  то условная энтропия равна:

то условная энтропия равна:

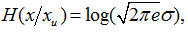

При нормальном распределении погрешности с дисперсией σ 2 условная энтропия равна:

где e — основание натуральных логарифмов; σ — среднеквадратическое отклонение погрешности. Сравнение (1.4) и (1.5) показывает, что средства измерений, имеющие существенно различные законы распределения погрешностей, могут давать одинаковое количество информации при измерении. В данном случае это будет обеспечено при выполнении условия  В связи с этим в качестве характеристики дезинформационного действия погрешности с произвольным законом распределения можно использовать энтропийное значение погрешности.

В связи с этим в качестве характеристики дезинформационного действия погрешности с произвольным законом распределения можно использовать энтропийное значение погрешности.

Энтропийным значением погрешности считается наибольшее значение погрешности с равномерным законом распределения, которое вносит такую же дезинформацию, как и погрешность с данным законом распределения вероятностей.

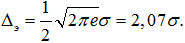

Если погрешность описывается нормальным законом распределения, то энтропийное значение погрешности равно:

Аналогично определяется энтропийное значение погрешности для любого конкретного закона распределения. Зависимость между энтропийным и среднеквадратическим значениями погрешности может быть представлена в виде:

где k — энтропийный коэффициент.

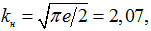

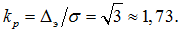

Энтропийный коэффициент определяется видом закона распределения вероятностей погрешностей. Для нормального (гауссовского) распределения энтропийный коэффициент в соответствии с формулой (1.6) равен

а для равномерного распределения

Полученные значения энтропийного коэффициента характеризуют область его значений, соответствующую большинству реальных законов распределения вероятностей погрешности. Анализ значений энтропийного коэффициента позволяет сделать вывод, что при одинаковом среднеквадратическом значении погрешность, распределённая по нормальному закону, вносит большую дезинформацию, чем погрешность, распределённая по равномерному закону. Более того, дезинформационное действие погрешности с любым другим законом распределения меньше дезинформационного действия погрешности с нормальным законом распределения при их одинаковых среднеквадратических значениях.

Информационный подход даёт возможность с единых позиций анализировать любые средства измерений (измерительные преобразователи, измерительные приборы, измерительные информационные системы) как в статическом, так и в динамическом режимах работы, выявлять взаимосвязи различных технических характеристик средств измерений, оптимизировать эти характеристики и оценивать предельные возможности используемых средств измерений.